“מתכנת אחד יכול לשלוט על צבא שלם”, מסביר פרופ’ טובי וולש, מנהל קבוצת מחקר ב-wnsw, אוניברסיטת ניו סאות’ וולס . “כל כלי הנשק ההמוניים כבר אסורים בפיתוח, או בתהליכי איסור כזה – כלי נשק אטומיים, כימיים וביולוגיים. אנו חייבים להוסיף את כלי הנשק האוטונומיים לרשימה זו, שמבחינה מוסרית איננו מסוגלים לקבל”.

חוקרים מובילים מתחום הרובוטיקה והתבונה המלאכותית משתי מדינות בולטות בחבר העמים הבריטי – קנדה ואוסטרליה, חתמו לאחרונה על מכתבים פתוחים הקוראים לראשי הממשלות לנקוט עמדה כנגד הפיכת בינה מלאכותית לנשק.

בראיון לאתר הידען מסביר פרופ’ טובי וולש, מנהל קבוצת מחקר ב-wnsw, אוניברסיטת ניו סאות’ וולס, כי המכתב הוכן לקראת ועידת פירוז הנשק של האו”ם שהתקיימה בז’נבה בחודש נובמבר 2017.

עד כה חתמו 19 מדינות על איסור פיתוח של נשק אוטונומי; אלג’יריה, ארגנטינה, בוליביה, צ’ילה, קוסטה ריקה, קובה, אקוודור, מצרים, גאנה, גואטמלה, הוותיקן, מקסיקו, ניקרגואה, פקיסטן, פנמה, פרו, ונצואלה, זימבבואה והרשות הפלסטינית.

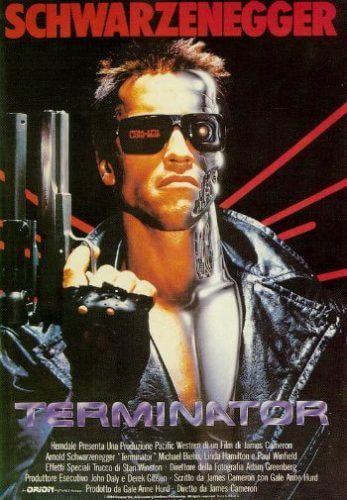

כלי נשק אוטונומיים מתוארים גם כרובוטים רוצחים, כדי לצרוב תיאור שלישי במוחם של מרבית בני האדם. “איננו מדברים על מחסל בנוסח קולנועי של ‘שליחות קטלנית'”, מסביר פרופ’ וולש, “אלא טכנולוגיות פשוטות בהרבה שניתן יהיה ליישם בתוך שנים ספורות. למשל רחפן טורף שיטוס מעל שמי עיראק ללא הנחיה מרחוק של אדם אלא באמצעות מחשב. כעת למעשה, מחשב יוכל לקבל את ההחלטה הסופית לחיים ולמוות – האם לירות את הטיל – או לא”.

לדבריו, “אינני חושש מבינה מלאכותית חכמה, אלא דווקא מבינה מלאכותית טיפשה. אנו ניתן למכונות את הזכות לקבל החלטות חיים ומוות, אך הטכנולוגיה הנוכחית אינה מסוגלת לקבל החלטות נכונות”.

“בטווח הארוך, כלי נשק אוטונומיים יקבלו יכולות גדולות יותר – אך אני מודאג שמישהו יהפוך אותם לכלי נשק שיערערו את הסדר הגיאופוליטי, ולבסוף יהפכו לעוד סוג של נשק להשמדה המונית. המכתב האוסטרלי הופץ בו זמנית עם המכתב הקנדי שהופנה לראש הממשלה ג’סטין טרודו, עליו חתמו שניים ממייסדי תחום הלמידה העמוקה והבינה המלאכותית – ג’פרי הינטון ויהושוע בנג’יו.

מהפכה צבאית שלישית

“אני ארגנתי את המכתב האוסטרלי שעליו חתמו 122 מדענים ובהם עשרות דיקנים ומנהלי מחלקות אוניברסיטאיות, וכן פרופסורים ל-AI ורובוטיקה”, אמר וולש.

במכתבים כותבים החוקרים כי נשק אוטונומי קטלני הנעדר בקרה אנושית, נמצא בצד הלא-נכון של המוסר. לדברי פרופ’ וולש, הם פנו לראשי מדינתם שיתחייבו לעבוד עם מדינות אחרות כדי לכלול את הנשק האוטונומי כאחד מהפיתוחים האסורים, בדומה לנשק ביולוגי ונשק כימי.

הוא אומר כי “האו”ם מקשיב לקולות הללו, שנשמעים כבר מספר שנים והוא מגיב. אבל כמו כל הדברים בדיפלומדיה, ההתפתחות אינה מהירה”.

בדצמבר 2016, לאחר שלוש שנים של שיחות לא פורמליות, החל האו”ם בסדרת שיחות רשמיות בתוך קבוצה של מומחי ממשלות שכללו אנשי טכנולוגיה, משפט ומומחים פוליטיים שנבחרו על ידי המדינות החברות להמליץ על פעולה, אך לא לשאת ולתת על הסכם איסור הפצת נשק אוטונומי.

הסכנה באי קיומו של הסכם כזה, אומר פרופ’ וולש, “היא שיתפתח מירוץ חימוש לפיתוח כלי נשק אוטונומיים חזקים יותר ויותר. זו תהיה מהפכה צבאית שלישית – אחרי המצאת אבק השריפה ופיתוח פצצות האטום. המהפכה השלישית הזו תהווה צעד נוסף במהירות וביעילות שבהן נשק כזה יוכל להרוג”.

“מתכנת אחד יכול לשלוט על צבא שלם”, הוא מסביר. “כל כלי הנשק ההמוניים כבר אסורים בפיתוח, או בתהליכי איסור כזה – כלי נשק אטומיים, כימיים וביולוגיים. אנו חייבים להוסיף את כלי הנשק האוטונומיים לרשימה זו, שמבחינה מוסרית איננו מסוגלים לקבל”.

פרופ’ טובי וולש, מנהל קבוצת מחקר ב-wnsw, אוניברסיטת ניו סאות’ וולס. צילום: יח”צ

מי מפתח נשק כזה?

ארצות הברית, סין, רוסיה, בריטניה ומדינות מתקדמות אחרות, כולל ישראל.

“חומר הגלם” של פצצתAI הם אנשים מוכשרים. האם ארגוני טרור עלולים לשלם להם כדי לפתח נשק כזה? איך נוכל לבקר זאת?

“הדרך לבקר כלי נשק אלה היא אותה דרך שבה אנו מבקרים טכנולוגיות אחרות כגון נשק כימי ונשק ביולוגי. לא יכולנו להפסיק לקדם את הכימיה, אך הפכנו ללא קביל מוסרית את השימוש בנשק כימי, ונאסר על יצרניות נשק למכור אותם. בדרך זו הם לא נמצאים למכירה וגם לא זמינים בשוק השחור, ולכן השימוש בהם מוגבל ביותר. אנו יכולים לקוות שאותו הדבר יקרה גם עם הנשק האוטונומי”.

“איננו יכולים לעצור את פיתוח הבינה המלאכותית. היא יכולה לשמש לצרכי שלום רבים כגון מכוניות אוטונומיות, אך אנו יכולים להפוך ללא מוסרי ולא מקובל שימוש בהם להרוג, כפי שעשינו במקרה של כלי נשק כימיים וביולוגיים. בכך אני מקווה, נהפוך את העולם לבטוח יותר”.

מה אתה יודע על הנעשה בישראל בתחום זה?

“ישראל לא תהיה בטוחה אם וכאשר נשק אוטונומי יתקיים. הם יצטרכו להגן על עצמם מפני כלי נשק איום זה”.

הכתבה התפרסמה באתר אנשים ומחשבים במסגרת מדור שבועי העוסק בתחום התבונה המלאכותית.

14 תגובות

יריב, ד’

יש הרבה נשקים שאסורים לשימוש, ומי שעובר על החוקים האלה יכול להמצא בבעיה רצינית, כך שלחוקים יש משמעות.

מצד שני -נשק אוטונומי תמיד היה, עוד מימי קדם. אנחנו לא מעדיפים מוקשים שינטרלו את עצמם בסיום המלחמה? או טילי מטוסים שיידעו לא להפיל מטוסים ידידים כאלה (וזה כבר קיים מזמן).

יש חשיבות למכתבים כאלה, כדי לעלות את הבעיות. עדיף להתעלם מהסכנות? צריך להבין של”בינה מלאכותית” אין הגדרה, כך שבאמת אין הרבה משמעות ביצועית.

בכל מערכת הפעלה היום יש בינה מלאכותית, בכל טלפון ובכל אוטו.

אנונימי

נשק אטומי הומצא בארה”ב כי פחדו שמישהו אחר ימציא אותו קודם. זה נשק התקפי שנועד לעשות נזק מירבי, הן ברכוש והן בחיי אדם.

אין שום ראיות לכך שהרתעה גרעינית חוסכת חיי אדם. מי שטוען אחרת – שיוכיח.

מדובר במסמך חסר ערך שאין לו שום רלוונטיות במציאות. בינה מלאכותית מהווה מכפיל כוח אדיר שאף צבא ואף מפקד בצבא לא יהיה מוכן לוותר עליו בשדה הקרב המודרני. כבר היום יש לא מעט אלמנטים של בינה מלאכותית בשדה הקרב, למשל טיל הגיל (ממשפחת ספייק) הישראלי משתמש בבינה מלאכותית כדי לפגוע במטרות גם בתנאי ראות קשים וגם כאשר המטרה מנסה להסתתר או להתחמק, במטוס ה F-35 שקיבלנו יש לא מעט בינה מלאכותית שבלעדיה המטוס חסר ערך.

מי יהיה מוכן לוותר על כל זה?

122 מדענים חתמו על מסמך…

גם אם 122,000 מדענים יחתמו על מסמך זה לא ישנה דבר. עבודתם של אותם מדענים עצמם תנוצל לבניית נשק השמדה המוני או לתוכנית נבזית ומטופשת אחרת, כי מקבלי ההחלטות תמיד יהיו אנשים חמדנים וקצרי-ראות. (משל יותם, ספר שופטים פרק ט’)

זה די ברור שלפשתינישתים אין בעיה להתנגד לנשק גרעיני.

הרי, להם אין אותו.

אבל למדינת ישראל יש ויש. וגם לארה’ב.

ובכלל,

אין בעיה עם נשק אטומי.

כמו שאין בעיה עם רכב.

וכמו שאין בעיה עם סכין.

הנשק האטומי הומצא כדי להגן על בעלות הברית, כנגד עלובי החיים (בזמנו היטלר ימח שמו וכיום אצלנו עם אבו-אדולף מאזן יחרב ביתו עליו ועל משפחתו)

הבעיה היא כאשר הדברים האלו נופלים לידיים של עלובי נפש. כמו הפלשתינים ושאר מחבלי העולם.

יש לי בעייה עם הכתבה הזו…

נדמה, שככל שעובר הזמן, הרג המונים נטוּל הבחנה אינו שייך לעולם בו אנו חיים.

האדם היום, הוא נשוא הכיבוש.

הכיבוש הוא פיננסי בעיקרו.

ומאחר וכך – חיסול אדם, דומה לשיחרור שטח (ששנים לפני כן נלחמו בגינו)

האדם היום – לאורך כל חייו חייב להשתמש בשרותים שמספקים לו התאגידים (בין אם מדובר ברפואה, סיעוד, טכנולוגיה ועוד). ומאחר וכך אדם מת שווה כמעט כלום.

יוצא מזה, שככל שיעבור הזמן, אנשים יחיו יותר (בני 5 היום יחיו ללא ספק יותר מ 100 שנה) והיכולות של התאגידים רק יתחזקו.

נשאלת השאלה – מה תפקיד הרגולציה (המחוקק) בכל המשוואה הזו?

אלו צריכים להראות כאילו פניהם לאזרח

אבל בּפּוֹעל (וכן, צריך להיות דגש בפּ׳) אלו משרתים את התאגידים.

ולכל הסיפור הזה אפשר לקרוא מל״ע-3 (מלחמת עולם שלישית).

————

הבעייה עם המלחמה הזו היא: שאנחנו יודעים לזהות מלחמה רק כאשר יש טנקים, אווירונים וכלי משחית אחרים ובמלחמה שאני מדבר עליה לאלו אין מקום.

להרוג אדם – זה לשרוף כסף – וכסף, זה הדבר אשר בגינו מתקיימת המלחמה.

———–

{יכול להיות שאני מדבר שטויות… אבל זה מה שאני מרגיש. כל הקטע הזה של חיסולים קשור אולי לארגוני טרור למניהם אבל כבר לא ממש קשור לעולם בו אנו חיים}

כבר אסימוב הבין לפני למעלה משישים שנה את חוסר התוחלת שבהגבלת טכנולוגיות “מסוכנות” – ברבות הזמן פשוט עוקפים אותן ומגיעים לאותן בוצאות בדרך זולה ופשוטה בהרבה. משהו שהחוקרים הללו פשוט לא מסוגלים לתפוס.

אז בעוד 20 שנה בערך, לא תהייה שום בעייה ליוסי לבקש מהבינה המלאכותית שלו להוריד מודל של רחפן, להדפיס אותו במדפסת התלת מימד הביתית ולהורות לו לשחרר שקיות ניילון מלאות במים בדיוק על ראשו של השכן המעצבן שלו דוד שהעליב אותו בוואצאפ השכונתי. עכשיו תנסו למצוא בינה מלאכותית שתוכל למנוע מקרים כאלו, או חמורים יותר.

פרט לכך, ראיתי שהרשות הפלשתינאית חתמה על האמנה הזו. אין כל פלא בכך בהתחשב בעובדה שאין להם שום בעיה לגייס בעלי בינה טבעית כדי שישמשו כרכיבי הפעלה מתכלים לחגורות הנפץ ומשאיות התופת שלהם.

נוסטרדמוס

אתה רחוק מלהיות ביל גייטס… אתה אדם חסר הבנה ואכול שנאה. בגלל טיפשים כמוך, האיסלם האלים מצליח כל כך.

כל העולם הנאור נגדך… מסכן שלי…

כל ההגבלות האלה מטרתם אחת. להגביל את כוחו של המערב להילחם בשטן האיסלאמי הברברי והטיפש שלא מסוגל לפתח כאלה טכנולוגיות

אל תבלבל את המוח, אתה ימיני כמו שאני ביל גייטס. כמו ששלום עכשיו רוצים שלום, כמו שהשמאל הוא ציוני וכמו שהמבצע הצבאי הטורקי נקרא עלה של זית. זאת בדיוק הטקטיקה השמאלנית, להשתמש במילות שלום ולעשות מלחמה כדי לבלבל את האויב. המדינות המוסלמיות חותמות הסכמי חודייבה, הסכמי שקר כמו שמוחמד לימד אותם. בהסכם אוסלו עראפאת את הבטיח להלחם בטרור וביום למחרת חימש את כולם. הם ממנים ומקימים ארגוני טרור שאין להם שום בעיה להשתמש בכל נשק אפשרי

נוסטרדמוס

שוב אתה מביך את הימין? שמת לב שדווקא חלק גדול של המדינות שחתומות על האמנה נגד נשק אוטונומי הן מוסלמיות? ורשימת המדינות שלא חתומות על האמנה נגד מוקשים כוללת את ישראל וארה”ב?

נשק אוטונומי קיים כבר מאות רבות של שנים. כבר במאה השלוש עשרה הסינים השתמשו במוקשים. ואלף שנה לפני גן כבר היו מכמונות כמו רשתות ובורות מכוסים.

וגם אז – זה היה נשק נוראי.

בטח כי למוסלמים מותר כל סוגי הנשק ולמערב אסור לנצח צריך ליצור שיוויון כוחות. כי המוסלמים חלשים ומדוכאים.. הידיון שמאלני מעוות ומתועב

דבר אחד בטוח שאף אחת ברשימת המדינות החתומה לא תפתח בינה מלאכותית (והרשות זה לא מדינה),

אבל מעבר לזה בספק אם יש מנגנון שיכול להיבנה ולבלום את זה כי אין מעבר דיגטאלי של 0 בינה מלאכותית ל 1 בינה מלאכותית כמו בפיתוח של הנשק הגרעיני שבו או שיש או שאין נשק בנוסף אנחנו רואים את מה שווה יכולת הבקרה על פיתוח הנשק הגרעיני , בבינה המלאכותית המעבר הוא יותר אנלוגי התפתחותי ללא גבול ברור דבר שיהיה הרבה יותר קשה לפיקוח איך ניתן לסווג בכלל מערכת האם היא עברה את הסף אול לא

או שיש לה פוטנציאל לעבור את הסף,

לדוגמא מערכת הגנתית יכולה לשמש גם כהתקפית,

למשל איסור מערכת בינה מלאכותית שיכולה להגן ממטח טילים לא קובנציונאלי יאסר וכך ימותו מאות אלפי אנשים כדי לספק את תחושת הצדק והמוסר של המומחים? הרי ברור שלא מערכות כאלו יבנו ובגדול

ויש להם השלכה גם התקפית מובנית בתוכם שאולי בעימות בעצימות נמוכה לא תופעל אבל בוודאי שבעימות

כללי תופעל, חוץ מזה כל אחד שהיה חיל לא היה מתלבט אפילו עשרית שניה האם להכניס רובוטים לשדה הקרב או להקריב חיו על מזבח הצדק של המומחים , ברמה הטקטית זה יהיה לא מוסרי לשלוח חיל בסיכון אם הניתן לבצע את אותה פעולה עם רובוט מה שבטח לא מענין את מרבית המומחים כי סביר להניח שהדבר המסוכן ביותר שהם ראו בחייהם היא המקלדת של המחשב, עולה גם קצת חשד קטן שאצל חלק מהמומחים יש

גם נטיה אנטי מערבית שמכתיבות את הקמפין הזה ולא רק החשש מעלית מערכות לחימה מבוססות AI,

זה לא יהיה מפליא אם הם יתלבשו על ישראל ומערכות ההגנה שלה באמטלה של דאגה “כנה” למין האנושי.

למרות כל זה לא היתי מבטל את כל מה שהם אומרים בהחלט צריך לשמוע דעות שונות כי יש סיכונים שגם בלי להיות מומחה ניתן להבין אותם אבל אני סקפטי אם בכלל יהיה ניתן לבנות איזה מודל יעיל שמסוגל לפקח על מערכות כאלו גם בגלל ההיבטים הפוליטים הבין לאומים,